# COMS.HK 免费域名自 2014 年为香港用户带来优质的免费域名服务,由 3Domains 进行管理及营运。

如果注册不成功的,建议切换 香港节点

点击进入

点这里的小卡片,把个人信息输入好。

⚠️两个地方:手机号的区号和电邮地址,也就是注册时用的邮箱

注册好后,可以设置 A 记录、cname 等记录,还可以重定向,非常实用

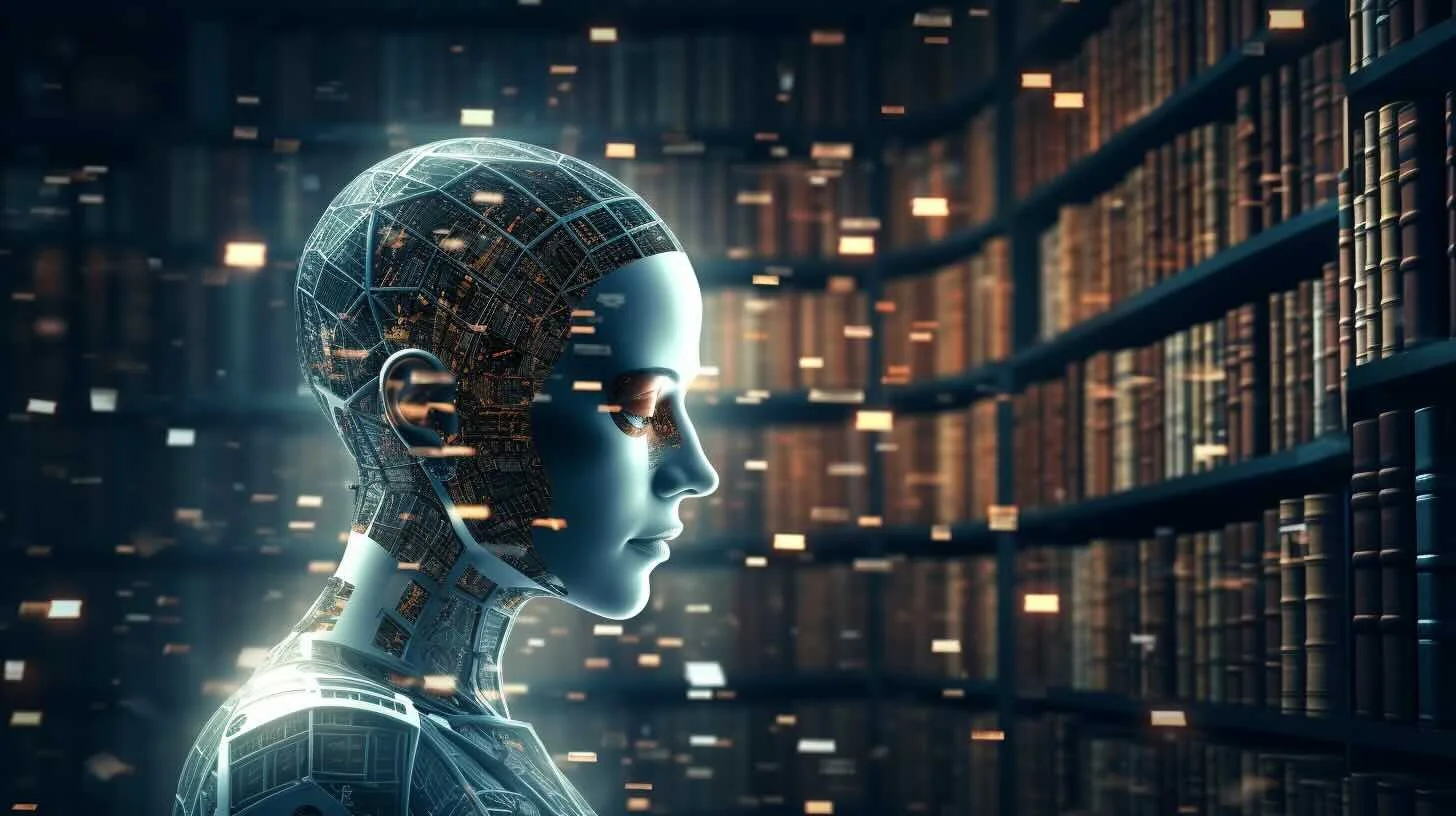

# Meta 宣布推出革命性开源大语言模型 Llama 3!

Meta 正式发布了下一代开源大语言模型 Llama 3,这标志着 AI 发展的新里程碑!该模型分为 80 亿和 700 亿参数两个版本,

被誉为 “Llama 2 的重大飞跃”,为大规模语言模型树立新标杆。

# Llama 3 的未来之路

值得一提的是,Llama 3 已与 Meta AI 助手深度集成,未来还将陆续在 AWS、Databricks、Google Cloud 等多个云平台上线,

并获得 AMD、Intel、NVIDIA 等硬件厂商的支持,进一步扩大应用场景。

这将为 Llama 3 带来无限的可能!

# Meta 的开源 AI 决心

该模型的发布彰显了 Meta 在开源 AI 领域的决心和影响力。我们有理由期待,Llama 3 将为自然语言处理、机器学习等 AI 前沿技术的发展注入新动力。

期待 Llama 3 的未来!

# 三种使用方式

在线使用( 推荐 )

本地直连使用

套壳使用

API 方式调用( 推荐 )

# 在线使用

入口:链接直达

不仅可以智能对话,也可以在线生成图片

# 本地直连使用

...

# 欣赏 AI 生成的视频效果

最新发布的 StreamingT2V 模型,由 Picsart AI Research 团队倾力打造,引领视频生成领域的革新!超越 Sora 模型,轻松创造长达 2 分钟(1200 帧)的高品质视频!更令人振奋的是,

这一开源模型与 SVD、animatediff 等其他模型完美兼容,为视频生成领域带来了前所未有的突破!

# 亮点总结

创造长达 2 分钟(1200 帧)的视频,超越以往模型

视频质量卓越,呈现高品质效果

与其他主流模型实现无缝衔接,提供更多创作可能性

开源免费,方便开发者使用和进行二次开发

# 免费体验

免费在线试玩:点击跳转

# 本地搭建

安装并安装 Python 3.10 and CUDA >= 11.6 环境 Python 3

、Cuda 下载

克隆开源项目至本地:

12git clone https://github.com/Picsart-AI-Research/StreamingT2V.gitcd StreamingT2V/

安装必备的环境:

123conda create -n st2v pyt ...

# 大悦城

# 温柔可爱的小猫咪

# 麻辣爽口的美味菜

# 背景

在许多问答应用程序中,我们希望允许用户进行来回的对话,这意味着应用程序需要对过去的问题和答案进行某种 “记忆”,并将这些问题和答案纳入当前思维中。

需要做到两件事:

提示:更新我们的提示,以支持历史消息作为输入。

情境化问题:添加一个子链,它接受最新的用户问题,并在聊天历史的上下文中重新表达。这是需要的,以防最新的问题引用了过去消息中的某些上下文。

例如,如果用户问一个后续问题,如 “你能详细说明第二点吗?"

,如果没有先前消息的上下文,这是无法理解的。因此,我们不能有效地执行检索这样的问题。

# 实战代码

# 所需依赖

12345678# BeautifulSoup (通常缩写为:BS4) 用于解析 HTML 和 XML 文件。它提供了从 HTML 和 XML 文档中提取数据的功能,以及对解析树进行导航的工具。import bs4from langchain import hubfrom langchain_community.document_loaders import WebBaseLoaderfrom langchain_communit ...

# 什么是 RAG

RAG 全称:Retrieval-Augmented Generation

RAG 是一种使用额外数据增强 LLM 知识的技术。

最强大的应用程序 LLMs 之一是复杂的问答 (Q&A) 聊天机器人。这些应用程序可以回答有关特定源信息的问题。这些应用程序使用一种称为检索增强生成

(RAG) 的技术。

LLMs 可以对广泛的主题进行推理,但他们的知识仅限于公共数据,直到他们接受培训的特定时间点。如果要构建可以推理私有数据或模型截止日期后引入的数据的

AI 应用程序,则需要使用模型所需的特定信息来增强模型的知识。引入适当信息并将其插入模型提示符的过程称为检索增强生成 (RAG)。

# RAG 架构

典型的 RAG 应用程序有两个主要组件:

索引:用于从源引入数据并对其进行索引的管道。这通常发生在离线状态。

检索和生成:实际的 RAG 链,它在运行时接受用户查询并从索引中检索相关数据,然后将其传递给模型。

# Indexing 索引

加载:首先我们需要加载数据。这是使用 DocumentLoaders 完成的。

拆分:文本拆分器将大 Documents 块拆分为 ...

# GPT-4 trained on YouTube transcripts GPT-4 在 YouTube 成绩单上进行训练

Based on the information provided in the search results, OpenAI reportedly used transcriptions of over a million hours

of YouTube videos to train GPT-4, its most advanced large language model. This was part of their effort to gather

high-quality training data, which is crucial for the development and improvement of AI models like GPT-4. The company

developed its Whisper audio transcription model to assist in this process, which allo ...

# 2026 年 AI 数据干旱

The potential for a data drought in 2026 is a significant concern for the artificial intelligence (AI) industry, as

highlighted by various sources. This situation arises from the rapid consumption of high-quality language data by AI

systems, such as ChatGPT, which are trained on extensive datasets compiled from the internet. The demand for this data

is outpacing the rate at which it is being produced, leading to predictions that the stock of language data suitable for

training A ...

# 概述

聊天模型是 LangChain 的核心组件。

聊天模型是一种语言模型,它使用聊天消息作为输入,并将聊天消息作为输出返回(而不是使用纯文本)。

LangChain 与许多模型提供商(OpenAI、Cohere、Hugging Face 等)集成,并公开了一个标准接口来与所有这些模型进行交互。

LangChain 允许您在同步、异步、批处理和流模式下使用模型,并提供其他功能(例如,缓存)等。

# 初始化

123456789101112131415161718192021222324252627import osfrom langchain_openai import OpenAIfrom langchain_openai import ChatOpenAIos.environ["OPENAI_API_KEY"] = 'api-key'os.environ["OPENAI_API_BASE"] = 'https://api.moonshot.cn/v1/'api_key = os.getenv(&quo ...

# 准备大模型实例

123456789101112131415161718import osos.environ["OPENAI_API_KEY"] = 'moonshot api key'os.environ["OPENAI_API_BASE"] = 'https://api.moonshot.cn/v1/'from langchain_openai import ChatOpenAIapi_key = os.getenv("OPENAI_API_KEY")base_url = os.getenv("OPENAI_API_BASE")print(api_key, base_url)model = ChatOpenAI( openai_api_base=base_url, openai_api_key=api_key, model_name="moonshot-v1-8k", temperature=1,)

# 案例 1

1 ...